E finalmente chegou meu invite para ser beta do “Gen-1” 👏👏👏👏👏 Fiz alguns testes iniciais que vou colocar aqui, mas já posso adiantar que achei bem estranho (tenho feito coisas mais legais com o stable diffusion + deforum + controlnet). O “Gen-1” tá rodando pelo Discord também (como o Midjourney) e esse beta ainda tá limitado a geração de vídeos de no máximo 3 segundos. Funciona assim: Você sobe um vídeo de no máximo 3 segundos e junto dele sobe uma imagem de referência para a I.A. do “Gen-1” estilizar o vídeo que mandou, ou seja, são 2 inputs, gerando 1 output, com o vídeo estilizado como resultado. Achei o vídeo que ele gera mais lento do que o original, parecendo meio truncado… enfim… é beta né? Mas achei interessante! Não fucei em nada ainda das configurações, parâmetros… nada. Gerei os vídeos só subindo os 2 inputs e mandando ele fazer.

O vídeo base que usei foi esse:

O input 2 para estilização do primeiro teste foi essa imagem:

E o resultado do output do primeiro teste foi esse:

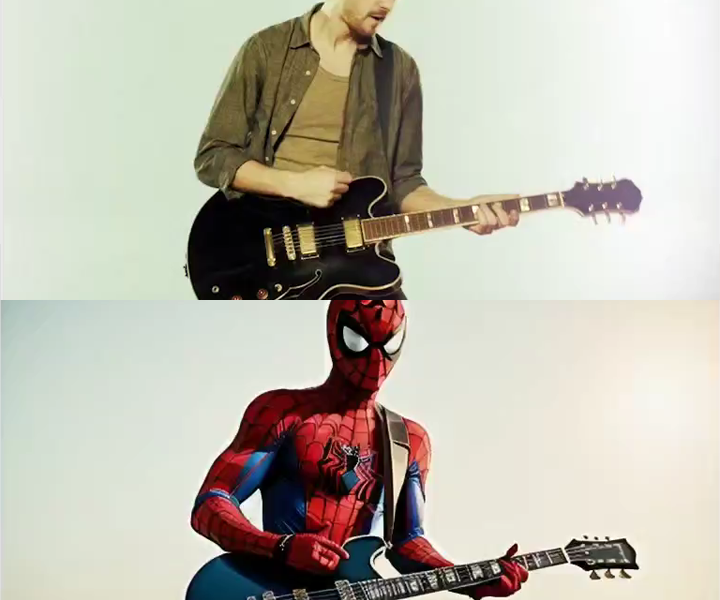

No segundo teste, subi a imagem abaixo como input 2 (usando o mesmo vídeo base como input 1):

E o resultado foi esse:

No terceiro teste o input 2 foi essa imagem abaixo:

Gerando esse vídeo abaixo como resultado:

E como um último teste, meti o louco, e subi a Monalisa (rs) como input 2:

E o resultado foi esse (acho que o que curti mais inclusive hehe):

É isso que testei até agora… Quero fazer mais testes, explorando melhor as configurações, parâmetros e ajustes na geração das imagens. Assim que tiver mais experimentos posto por aqui. Até já!

Leave a Comment