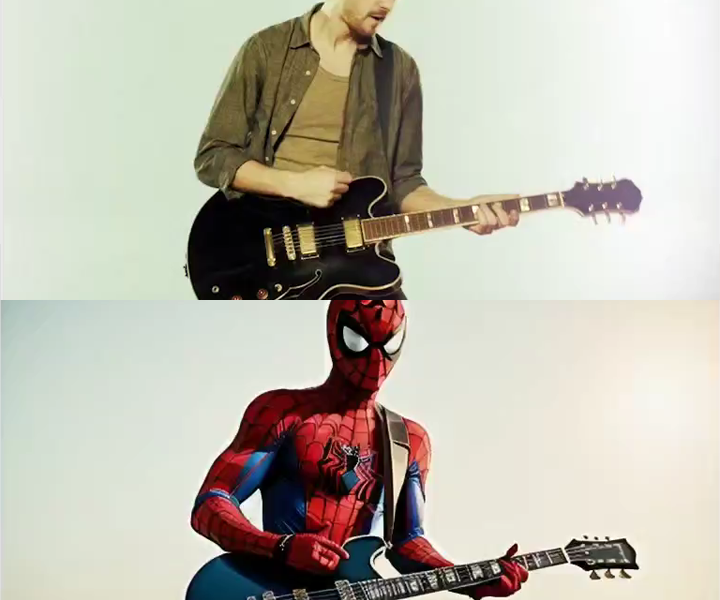

Ok… eu passei as últimas semanas meio obcecado por tentar treinar um modelo de A.I. com o meu rosto. Foram diversas tentativas iniciais e falhei miseravelmente em cada uma delas. Queria fazer isso de forma local e não dependendo de ajuda de cloud computing, colabs e etc… As primeiras tentativas foram pelo Dreambooth e logo percebi que não tenho GPU pra isso. Então tentei coisas mais leves como o LORA e também falhei miseravelmente. Outras tentativas como hypernetwork, unet e até por método de textural inversion acabaram me trazendo resultados não satisfatórios (rs). Até que então acabei encontrando o ‘fast dreambooth’, que roda mais liso, leve e solto, via colab (sim apelei rs). E eu gostei muito do resultado. Acabei treinando um modelo com o meu rosto e depois o modelo da minha namorada., dentro do mesmo modelo, mas em sessões diferentes, claro. Depois disso o desafio foi tentar juntar os 2 modelos em uma composição só dentro de um contexto. As imagens abaixo mostram um pouco do resultado que consegui…

Imagens criadas no Stable Diffusion com modelos treinados no DreamBooth por Renato Di Giorgio.

Leave a Comment