Há quase 10 dias atrás a extensão ‘CONTROLNET’ foi lançada pro Stable Diffusion e minha mente explodiu. Postei até isso aqui depois de fazer alguns experimentos usando o modelo MLSD dessa extensão e as zilhões de possibilidades que isso trouxe como ferramenta de trabalho pra muito profissional, principalmente na área de arquitetura, design de interiores, decoradores, etc.

Aí os devs dessa piração, não contentes, lançam uma atualização de ontem pra hoje que fez minha mente explodir de vez! 🤯 Na nova atualização eles adicionaram, entre várias novidades, a possibilidade ativar o ‘MULTI CONTROLNET’, que abre a possibilidade de você rodar 2 (ou mais) instâncias da ‘CONTROLNET’. Ah! legal… mas o que isso traz de bacana? Bom… existem muitas possibilidades nisso e a primeira delas é juntar por exemplo o processamento do MLSD com o OPEN POSE o que eleva o controle na geração de imagens por inteligência artificial pra outro patamar…

Deixo abaixo aqui o resultado de alguns testes iniciais dessa brincadeira… Claro, o update foi lançado hoje e mal tive tempo pra testar. O pouco tempo que tive já foi o suficiente pra me deixar muito (mas muito) mais empolgado com essa p… toda!😀

Vamos lá… a brincadeira começa igual ao post anterior que eu fiz, sobre o ‘CONTROLNET’ >> ‘MLSD’…

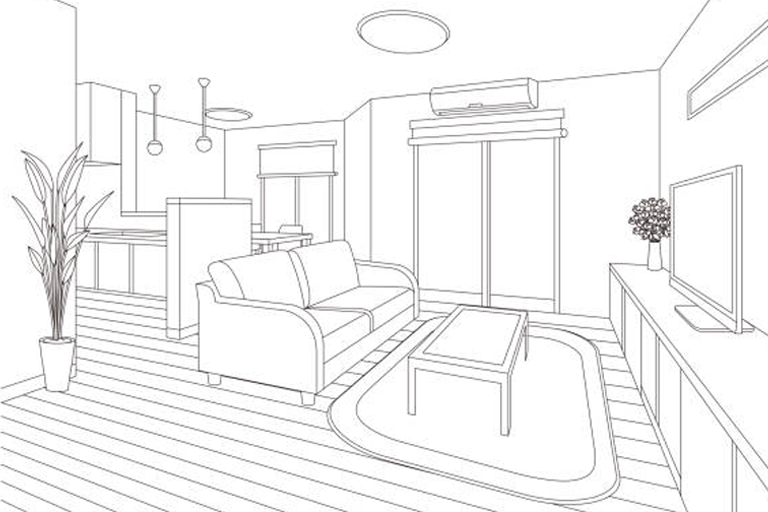

ETAPA 1: Peguei um esboço de um quarto (desenho em fundo branco só com linhas – é importante isso pro modelo MLSD do CONTROLNET entender e gerar o mapping certo pra geração da imagem)… foi essa imagem (abaixo), aqui que peguei… só ajustei ela pra ficar no tamanho da imagem que vou gerar (768×512).

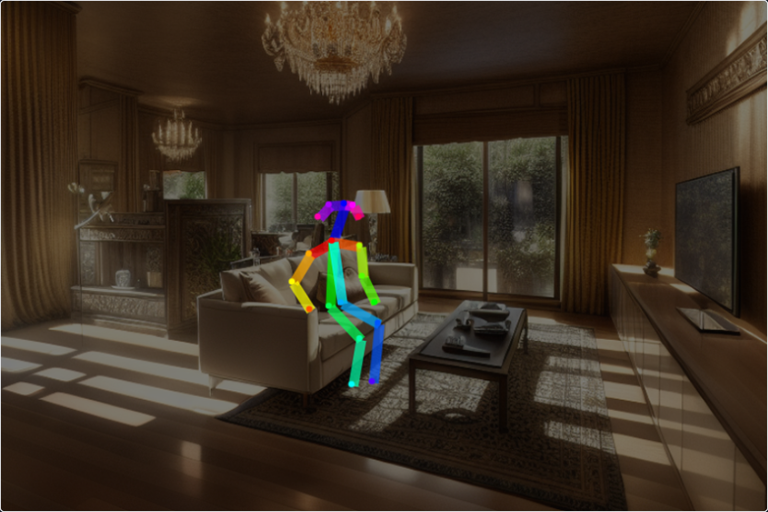

ETAPA 2: Botei o CONTROLNET (1a. instância – com o MLSD) pra trabalhar, gerando a imagem (sem muito encebração de prompt ou ajustes de parâmetros, só um teste inicial mesmo) abaixo:

Boooaaa! ficou legal! Agora é ir pra próxima etapa…

ETAPA 3: Abri a extensão ‘open pose editor’ (eu vou fazer um post dela aqui ainda e suas possibilidades), ajustei o canvas pro mesmo tamanho da imagem que vou gerar (768×512) e joguei como fundo, pra referência da posição do personagem que quero na cena, a próprima imagem do primeiro render (acima). Aí adicionei o ‘puppet’ do ‘open pose editor’ e ajustei ele pra ficar ali, sentadinho no sofá. E ficou assim:

Ok… ok… eu não sou muito bom de ajustar “bones” de poses bonequinhos puppets (rs) … mas vamos lá… pra etapa 4…

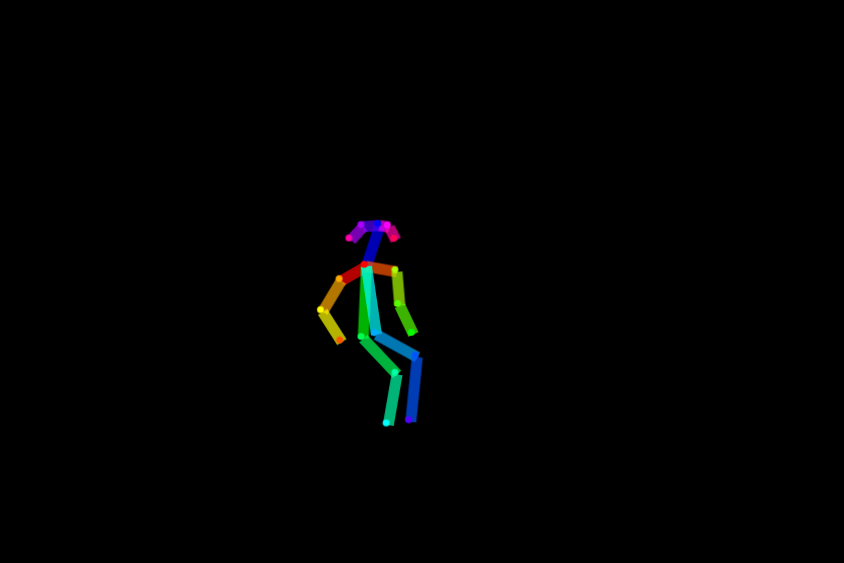

ETAPA 4: Salvei um png da pose (ele elimina a imagem de referência). Então a imagem gerada pela extensão (em referência a cena que estou criando) ficou assim:

ETAPA 5: Voltei ao ‘text2img’, onde tava lá a imagem do sketch na instância 1 do CONTROLNET com modelo do MLSD ativado e agora adiciono uma nova instância do CONTROLNET, dessa vez colocando o modelo ‘open pose’ e colocando a imagem que gerei na extensão ‘open pose editor’ como a imagem de referência pra ele…

ETAPA 6: MULTI CONTROLNET ativado com as 2 instâncias (MLSD + OPEN POSE) agora é só acrescentar o personagem que quero no início do prompt… coloquei um ELFO… “Um elfo sentado no sofá…” e o resto do prompt o mesmo… E o resultado foi esse:

Aahhh mas ele mudou a sala (mesmo mantendo o seed) sim… mudou! Porque eu renderizei a sala primeiro né? A ideia desse processo é vc renderizar com as 2 instâncias do CONTROLNET ao mesmo tempo… e já ter a noçao de como vai ficar e ir ajustando os parâmetros, seeds, prompts e etc… calma! (rs) a parada lançou hoje… então não sejam exigentes demais comigo (rs) … afinal de contas um ELFO entrou na cena… então a casa do ELFO foi decorada de outro jeito (rs). Mas vamos pra etapa final de refinamento…

ETAPA 7: Por fim dei uma refinada, enviando a imagem gerada pro ‘inpaint mode’, mascarei apenas o personagem e mandei renderizar de novo só ele, com o ‘denoising strength’ um pouco mais alto… e o resultado final foi esse:

É isso… CONTROLNET é f…. e isso é só o começo. Em breve quero postar mais sobre CONTROLNET (a parte de Img2Img dele e também recursos novos como o ‘GUESS’ que é ducarajo!). Quero também registrar aqui em breve experimentos com o modelo ‘open pose’, a extensão ‘open pose editor’ e outras maneiras de se ter mais controle das imagens geradas pelo Stable Diffusion com o CONTROLNET. Uma coisa eu tenho a dizer sobre isso… ficou pequeno pro MidJourney, Playground AI, e derivados… comeram poeira com a evolução do CONTROLNET… Até mais!

__

Criado no Stable Diffusion / Txt2Img + MULTI CONTROLNET por Renato Di Giorgio.

Leave a Comment